San Francisco – Non bastano touchscreen e comandi vocali: per Google il miglior modo di interagire con i wearable sono i gesti. Per questo, nel laboratorio ATAP – quello dedicato alla tecnologia avanzata – hanno messo in piedi Project Soli: per capire il modo migliore per tracciare i movimenti.

È venuto fuori che la soluzione migliore sarebbe l’uso dei radar, che anziché inviare un segnale per raccogliere un singolo dato crea un ampio cono in grado di intercettare interi oggetti. Problema: un radar non sta dentro un orologio.

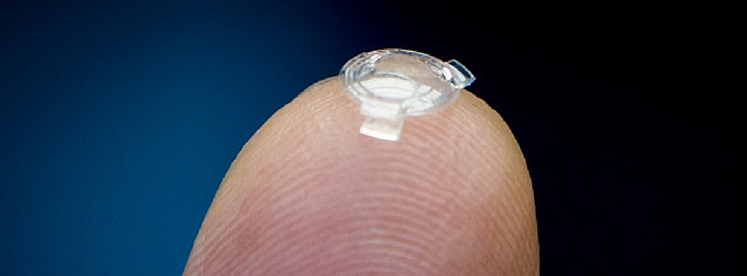

E qui entra in gioco la miniaturizzazione: il primo prototipo di Project Soli era uno scatolotto di diversi centimetri di lato; ora, quasi 10 mesi dopo, è un chip di 9 millimetri quadrati costituito da due antenne RF da 60 GHz che registrano fino a 10mila frame al secondo.

Project Soli può tracciare dove si trova la tua mano, dove si trova ogni singolo dito, in tempo reale e con una sensibilità di appena un millimetro: tenendo la mano ferma davanti al chip, verranno comunque segnalati 3mila movimenti al secondo. E qui entrano in gioco gli algoritmi auto-apprendenti di Google: riconoscendo i movimenti intenzionali, Project Soli può convertirli in comandi da inviare ai gadget. Puoi farci passare davanti una mano o far sfiorare due dita una sull’altra, come a girare una rotella.

“Nel quotidiano usiamo in continuazione le mani per comunicare e dovremmo essere in grado di usarle anche per interagire con la tecnologia”

ha detto Ivan Poupyrev, direttore dei programmi di ATAP. Dimentica gli ampi gesti, però: per comandare un accessorio con un display inferiore ai 2 polliciserve pensare in piccolo.

“Non serve sbracciarsi come dei matti davanti al Kinect”

con il giusto sistema di tracciamento si può arrivare ad alzare con precisione la luce, il volume, la temperatura, senza la necessità di toccare una manopola, ma con piccoli gesti quotidiani come il movimento del dito su un touchscreen. Solo che qui lo schermo non c’è, si fa tutto per aria.

Integrando Project Soli in uno smartwatch, ad esempio, si potrebbe ricreare una corona virtuale, per spostare le lancette (digitali) solo sfregando due dita davanti allo schermo. Un radar è in grado di raccogliere un numero impressionante di dati, mentre gli algoritmi di Google possono imparare a interpretarli e distinguere ogni movimento, fino a riconoscere le persone in base all’unicità dei suoi comportamenti. Una capacità che ha portato ATAP a creare anche Project Vault, il progetto per eliminare le password. Per i comandi gestuali serviva solo miniaturizzare un radar e per questo è nato Project Soli. Sui tempi di un suo utilizzo non ci sono informazioni, ma Google sta lavorando per rilasciare le API agli sviluppatori entro l’anno.

Via Wired